Liens de la barre de menu commune

Liens institutionnels

-

Bureau de la traduction

Portail linguistique du Canada

-

TERMIUM Plus®

-

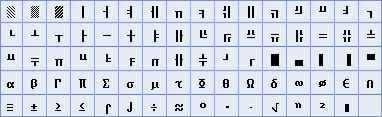

Titres

- Abrégé de traduction automatique

- Accord légitime

- Accroître son QC (quotient courriel)

- Adresses Web : Faut-il inclure « http:// » et « www »?

- Affaire Dame Action c. Sieur Recours. Cette action vaut-elle un recours?

- Aimez-vous la nouvelle orthographe?

- Ainsi que, de même que, comme, et les autres

- À la recherche du français perdu : la pertinence de Proust

- Améliorez la lisibilité visuelle grâce aux titres et sous-titres

- Après que et le subjonctif

- À propos de décade

- À propos d’« identifier »

- À travers le prisme de l’histoire : Complot acadien et traducteurs « frappés au cerveau »

- À travers le prisme de l’histoire : Erreurs de traduction historiques, fatidiques ou cocasses

- À travers le prisme de l’histoire : Jean L’Heureux : interprète, faux prêtre et Robin des bois

- À travers le prisme de l’histoire : John Tanner, un Indien blanc entre l’arbre et l’écorce (I)

- À travers le prisme de l’histoire : John Tanner, un Indien blanc entre l’arbre et l’écorce (II)

- À travers le prisme de l’histoire : Joseph de Maistre ou Alexandre Pouchkine? La confusion de Babel

- À travers le prisme de l’histoire : Le français, langue de travail dans l’Ouest

- À travers le prisme de l’histoire : Personnages colorés, privilèges et brillantes réparties

- À travers le prisme de l’histoire : Traduire dominion par « puissance » : était-ce une « absurde vanterie »?

- Aux verbes-signaux, arrêtez-vous!

- Baudelaire traduit en prison par un professeur de traduction

- Bien que : indicatif ou subjonctif?

- Bijuridisme canadien : questions d’harmonisation

- Bottleneck : Goulot ou goulet d’étranglement?

- Bousculade de que

- « capable » et « susceptible »

- Carbure ou carbone?

- CE livre ou LE livre

- Ce n’est pas dans le dictionnaire. Ce n’est donc pas… bon! ou la quête de la bonne préposition dans les ouvrages de référence

- Centre ou Palais des congrès?

- Cet accommodement est-il raisonnable?

- Changer de supermarché, vraiment?

- Cinquante ans d’interprétation parlementaire

- Classifier (to classify) ou classer (to classify)

- Clearance : un terme polysémique

- Combien faut-il être pour être plusieurs?

- « Comme il l’a été mentionné » : un intrigant pronom personnel

- Comment courir un risque

- Comment le français et d’autres langues ont façonné l’anglais

- Comment se faire octroyer une subvention

- Comment traduire l’expression safe and secure?

- Comment traduire lie quand on joue au golf

- Comme quoi l’ivraie de l’un peut être le bon grain de l’autre

- Communication claire et efficace : faciliter la lecture

- Communication claire et efficace : favoriser la rétention de l’information

- Communication claire et efficace : réduire le niveau d’inférence

- Comprendre les moteurs de recherche

- Concept : concept, idée, notion

- Conflit d’horaire, conflit de vocabulaire

- Dans le cybermonde des newbies

- De la graphie d’« attentat suicide »

- De la graphie du mot professionnèle

- De la vérification à l’audit

- Dépasser le mot image : une obligation pour le traducteur

- Des auxiliaires will et shall

- Désigner les espèces en péril au Canada

- Des mots pour parler des hybrides

- Des plans, des domaines, des ordres et autres curiosités

- Des services, une page Web… ça se partage?

- Deux locutions : à l’endroit de, avec comme objectif

- Development : Développement?

(développement, épanouissement, perfectionnement, aménagement ou géonomie?) - Directeur ou gérant

- Disability : déficience, incapacité, handicap…

- Documents échangés entre acheteur et vendeur : Appel d’offre = Inquiry?

- Don et ses dérivés

- Donnez généreusement, mais n’échangez pas

- Dont : un pronom capricieux

- Du bon emploi de « chez »

- Du métier dans le corps, de la passion dans l’âme

- Du noble mal tourné?

- Du secteur privé au secteur public : quelques exemples de néologismes de sens

- Du sexe de l’Act

- Écriture des numéros de téléphone : la parenthèse tombe

- Émergence d’une nouvelle terminologie bijuridique dans les lois fédérales

- Emplois abusifs d’avec

- En avoir ou pas

- Enfin, ils en sont arrivés à une entente

- « Enjoindre »

- Est-elle membre fondateur ou membre fondatrice?

- Était-ce le docteur Jekyll ou M. Hyde?

- Et ce : est-ce bien cela?

- Êtes-vous autantiste?

- Être à l’emploi de

- … Et vogue L’Actualité

- Executive summary

- Faire face à

- Fédéral-provincial ou fédéro-provincial?

- Fiche de famille : suggestion

- Genres et sexes en français

- Gens d’ici et gens d’ailleurs : comment les nommer

- Gestion de la qualité, contrôle de la qualité ou assurance de la qualité?

- Grammaire traditionnelle et grammaire nouvelle : la mère et la fille

- Grammaire traditionnelle ou nouvelle grammaire? Une fausse question, un vrai débat

- Grandeur et misère du participe présent

- Grandeurs et misères de la traduction collaborative en ligne

- Guidelines : lignes directrices

- Halifax en passant par Hull

- Imbécile – Tu n’en connais pas l’étymologie? – Oui, mais…

- « Imposer une sentence »

- Inactifs, les chômeurs?

- Informal : Informel

- Initiation aux macros pour les langagiers

- « Internet » : un casse-tête pour les langagiers

- Interprétation des conférences : Petite équipe, grande mission

- Inuit, un mot qui ne fait plus exception

- Jurilinguiste, terminologue-juriste et terminologue juridique : un problème terminologique?

- « Jusqu’à tout récemment »?!

La règle et l’usage - La conjonction puisque, et un possessif ambigu

- La dérive anglicisante du français technique

- La dictée est-elle dépassée?

- L’adjectif qualificatif : article de grande consommation directrice

- La langue et l’oreille: Vous êtes dur d’oreille? Non, c’est dur pour l’oreille

- La langue et Pavlov

- L’aménagement jurilinguistique au Canada

- La néonymie grand public

- Langue claire et simple : évaluer l’utilisabilité des documents

- Langue claire et simple : rédiger des documents lisibles

- Langue claire et simple : rendre le message intelligible

- Langue claire et simple : surmonter les obstacles à la littératie

- Langues nationales et acquisition de connaissances spécialisées en traduction technique

- La normalisation en common law en français au Canada : Une étude de cas

- La petite histoire d’une expression : À la bonne franquette

- La petite histoire d’une expression : Avoir des yeux de lynx

- La petite histoire d’une expression : C’est une autre paire de manches

- La petite histoire d’une expression : Découvrir le pot aux roses

- La petite histoire d’une expression : Être laconique

- La petite histoire d’une expression : Être le dindon de la farce

- La petite histoire d’une expression : Faire ou ne pas faire long feu?

- La petite histoire d’une expression : Perdre son latin

- La petite histoire d’une expression : Rester bouche bée

- La petite histoire d’une expression : Se faire l’avocat du diable

- La petite histoire d’une expression : Tenir le haut du pavé

- La petite histoire d’une expression : Un vent à (d)écorner les bœufs

- La « postposition »

- La reconnaissance vocale et les langagiers

- La règle de la supériorité

- La renaissance d’une langue

- La sécurité de vos données, ça vous intéresse?

- La simplicité volontaire en traduction

- La terminologie de la nouvelle grammaire

- La terminologie des gangs de rue sous la loupe

- L’athlétisme, discipline reine des Jeux

- L’aube du troisième millénaire, déjà?

- La vérification de l’exactitude technique de la traduction

- Le COSLA, une occasion rêvée de simplifier le langage administratif

- Le courriel : bénédiction et malédiction

- « Le courrier des lecteurs » : Ce n’est pas le moment de biaiser!

- « Le deuxième plus important »

- Le français victime du hit?

- Le genre des sigles

- Le jour et la nuit

- Le legs de McLuhan

- Le mot PATTERN et sa myriade d’équivalents

- L’endogénisme linguistique au Québec

- Le point sur la nouvelle orthographe

- L’équivalent français de common law

- Les 8 et 9 novembre « prochain » ou « prochains »?

- Les anglicismes insidieux

- Les années quatre-vingt ou quatre-vingts?

- Les avatars d’un mot

- Les caprices de l’usage : le cas de prévu

- Les centres de jurilinguistique au Canada

- Les changements climatiques, un problème singulier

- Le sens d’amender s’est-il modifié?

- Le Service SVP, d’hier à aujourd’hui

- Les fonctionnalités des mémoires de traduction

- Les injures racistes ont-elles leur place dans les dictionnaires?

- Les jeux de caractères et leurs mystères…

- Le slavon liturgique, ça se lit comme un roman… ou presque!

- Le sous-titrage vocal

- Les outils d’analyse de la nouvelle grammaire : dessine-moi une phrase

- L’espace insécable

- Les papillons pris aux filets de la langue

- Les problèmes posés par l’emploi de l’épithète

- Les subtilités de la politesse

- Les traducteurs et la recherche terminologique ponctuelle au 21e siècle

- Les « ventres à louer »

- Lettre ouverte aux jeunes langagiers

- Le verbe à tout faire

- Le verbe focaliser et les compléments de temps

- L’évolution de la méthodologie : un périple dans le temps

- Lexique panafricain de la femme et du développement

- « L’heure est grave », a analysé le ministre.

Quelques réflexions sur les incises - L’homme et la machine, duo productif… et positif?

- Lié/relié et la cohérence dans les énumérations

- L’indexation de la piastre

- L’informatique dans les nuages

- L’innovation et la norme dans les pratiques de rédaction non sexistes

- L’innovation et la norme dans les pratiques de rédaction non sexistes (2e partie)

- L’Institut d’été de jurilinguistique prend de l’ampleur

- L’inversion dans l’incise

- « LITERACY » et « INFORMATION LITERACY »

- L’obligation sans « devoir »

- Lumières sur un laissé-pour-compte : le terme hakapik

- L’utilisation des corpus en traduction

- Lutte à vs lutte contre

- Madame la sénatrice?

- Maison à vendre, oui mais par qui?

- Manual : Manuel ou Guide

- Ma quête d’information en 2010

- Mémoires de traduction et traduction automatique

- Memorandum : Mémorandum? Note?

- Mil aurait-il franchi ses derniers milles?

- Mondialisation : les langagiers oubliés

- Mon rapport au dictionnaire (partie 1)

- Mon rapport au dictionnaire (partie 2)

- Mots de tête : « ajouter l’insulte à l’injure »

- Mots de tête : « à l’année longue »

- Mots de tête : « à l’effet que »

- Mots de tête : « à même »

- Mots de tête : « anxieux de » + infinitif

- Mots de tête : « à ou ou? »

- Mots de tête : Arguez, arguez, il en restera peut-être quelque chose

- Mots de tête : « à toutes fins pratiques »

- Mots de tête : « à travers le monde » et « dans tout le pays »

- Mots de tête : « aux petites heures »

- Mots de tête : « avant-midi »

- Mots de tête : Avez-vous de la tchatche?

- Mots de tête : « avoir le dos large »

- Mots de tête : « ça augure bien mal »

- Mots de tête : « comme étant »

- Mots de tête : « dans le même bateau »

- Mots de tête : Deux mal aimés

- Mots de tête : De vigne en branche

- Mots de tête : Dévoiler à tout vent

- Mots de tête : « différend sur la différence »

- Mots de tête : « du même souffle »

- Mots de tête : « élaboré »

- Mots de tête : « en autant de »

- Mots de tête : « en autant que »

- Mots de tête : « en bout de » à toutes les sauces

- Mots de tête : « en charge de »

- Mots de tête : « en d’autres mots »

- Mots de tête : Endosser, un verbe qui se porte bien

- Mots de tête : « enjeux »

- Mots de tête : « en plus de » + infinitif

- Mots de tête : « en rapport avec »

- Mots de tête : « en rapport avec » (prise 2)

- Mots de tête : « en termes de »

- Mots de tête : « en tout et partout »

- Mots de tête : Entre taille et grandeur

- Mots de tête : « être à son meilleur »

- Mots de tête : « être familier avec »

- Mots de tête : « être (ou ne pas être) sorti du bois »

- Mots de tête : « faire (du) sens »

- Mots de tête : « faire sa marque »

- Mots de tête : « faire sa part »

- Mots de tête : « hors de question »

- Mots de tête : « il me fait plaisir »

- Mots de tête : « impliqué »

- Mots de tête : « incidemment »

- Mots de tête : « intéressé à » + infinitif

- Mots de tête : « jeter l’enfant avec l’eau du bain »

- Mots de tête : L’art de se tirer (une balle) dans le pied

- Mots de tête : Le nez qui voque

- Mots de tête : L’inclusion pour tous

- Mots de tête : « livrer la marchandise »

- Mots de tête : « loose cannon »

- Mots de tête : L’opportunité fait-elle le larron?

- Mots de tête : « Marcher des milles ou faire des kilomètres à pied? »

- Mots de tête : « mordre la main qui nourrit »

- Mots de tête : « non seulement ou de l’inversion du sujet »

- Mots de tête : « par le biais de »

- Mots de tête : « partisan(n)erie »

- Mots de tête : « paver la voie »

- Mots de tête : Peut-on manger dans la main de quelqu’un avec une cuiller d’argent dans la bouche?

- Mots de tête : « plus souvent qu’autrement »

- Mots de tête : « premier » et « dernier »

- Mots de tête : « prendre avec un grain de sel »

- Mots de tête : « revers de la main »

- Mots de tête : « (se) traîner les pieds »

- Mots de tête : « siéger à, dans ou sur? »

- Mots de têtes : « mon nom est »

- Mots de tête : « sous l’impression que »

- Mots de tête : « supposé » + infinitif

- Mots de tête : « supposément »

- Mots de tête : « tel que » + participe passé

- Mots de tête : « tentative de » + infinitif

- Mots de tête : « tournant du siècle »

- Mots de tête : « tous et chacun »

- Mots de tête : Traduire « eventually » par « à terme »? Éventuellement…

- Mots de tête : Trente ans après

- Mots de tête : Un adverbe qui se fait rare

- Mots de tête : Un « barbare » au Palais-Bourbon

- Mots de tête : « une table à mettre »

- Mots de tête : Un événement qui tourne à la manifestation

- Mots de tête : Un imposteur dans la maison

- Mots de tête : Un mot qui sème la division

- Mots de tête : Un profil à deux faces

- Mots de tête : « Un tapis rouge qui vire au bleu »

- Mots de tête : Un visa pour « émettre »

- Mots de tête : « vocal »

- Mots de tête : « vœu pieux »

- Mots de tête : Vous avez dit animisme?

- Mots de tête : « voyage en étrange pays, où la lune boit, les vaches mentent et les renards font l’café »

- Mots de tête : « you can’t have your cake and eat it too »

- Ne jetez pas l’éponge!

- Ne vous laissez pas embarquer!

- N’importe quel ou lequel?

- Non seulement n’a-t-il pas raison, mais encore il a tort!

- Non seulement ou le sujet attrapé par la queue

- Nos voisins les « États-Uniens »

- Nouvelle orthographe : un sujet bien d’actualité

- œuvre monumentale (…)

- Officers et Officials

- Ombudsmans? Ombudsmen? Le pluriel des mots d’origine étrangère

- Organisation ou organisme?

- Où il sera question de veille et d’intelligence

- Pas d’accent sur les sigles

- Pensez-y bien avant de partager vos opinions

- Petit cours sur le verbe confirmer

- Petite histoire du terme « sida »

- Petite montée de lait

- Petit lexique d’expressions composées avec clearance

- Pièges à éviter à la radio… et à la télé

- Pléonasme littéraire et pléonasme vicieux

- Plus de ou plus que

- Plus important,…

- Policy et policies

- Ponctuation, trait d’union et temps de verbe

- « Pour atteindre »

- Pour des conversations par Internet réussies

- Pour Mémoire

- Pour traduire Twitter

- Précisions et distinctions, 1

- Précisions et distinctions, 2

- Prendre pour acquis

- Préséance & ligatures

- Prévoir et précéder

- « Proactif » dans le vocabulaire de la gestion

- Problèmes de syntaxe

- Project : Projet?

- Puis, les années ont passé…

- Quand on ignore impunément une mesure drastique

- Quarante ans d’évolution en un clin d’oeil

- Quelques remarques sur la concordance des temps

- Qu’est-ce qu’un wiki?

- Question de typographie

- Quitter dans l’absolu

- Reculer d’abord ou sauter tout de suite?

- Réformer sans défigurer

- Regard sur la terminologie adaptée à l’interprétation

- Réhabilitons nos chevreuils

- Renseigner un champ, carter un ado

- Responsable, mais de quoi?

- Retention : un problème complexe pour le traducteur et le terminologue

- Retour sur le mot globalisation

- Retour sur tel que

- Rêves réalistes d’un langagier

- Risques à prendre ou à courir

- Royalties

- « S’assurer que »

- S’avérer vrai, s’avérer faux?

- Secrets bien gardés des mémoires de traduction

- Se porter candidat – candidate

- Shale gas : gaz de schiste ou gaz de shale?

- Shy, lazy … in other words: real nice!

- Simple ou double?

Re(s)soulever la question, c’est re(s)semer le doute - Si vous êtes d’accord…

- Soit… soit…

- Stupéfait et stupéfié

- Sûreté et Sécurité

- Sur ponterelle ou au mouillage?

- Survie ou survivance

- Taxinomie ou taxonomie? Quand l’usage s’emmêle

- Tendances

Les logiciels libres (et souvent gratuits) du domaine public - Tendances

Le supplice a assez duré

(Libérez les données prises en otage!) - Terminologie autochtone : une terminologie en évolution qui se rapporte aux peuples autochtones au Canada

- Timeo hominem unius libri

- Titres des lois et règlements : quelques règles

- To account for – Is accounted for by

- To affect

- To demonstrate : démontrer ou montrer?

- Traduction et tauromachie

- Traduire dans le domaine de la sécurité, c’est dur, dur, dur!

- Traduire le monde

- Traduire le monde : 30 ans de nouveaux noms de pays

- Traduire le monde : Amender la constitution?

- Traduire le monde : Atlas et graphies savantes

- Traduire le monde : Changer le monde

- Traduire le monde : Chercher dans Internet?

- Traduire le monde : Chinoiseries occidentales

- Traduire le monde : Commonwealth ou Communauté?

- Traduire le monde : Congolais, dites-vous?

- Traduire le monde : De l’Afrique

- Traduire le monde : De l’Allemagne

- Traduire le monde : Des noms! Des noms!

- Traduire le monde : Deux pays, deux systèmes politiques

- Traduire le monde : Élision, omission et toponymes

- Traduire le monde : États-Uniens ou Américains?

- Traduire le monde : Êtes-vous international?

- Traduire le monde : Gentilés et genre grammatical : des dictionnaires toujours aussi imprécis

- Traduire le monde : Grande-Bretagne ou Royaume-Uni?

- Traduire le monde : Juifs, Hébreux, Israélites… et Sémites

- Traduire le monde : La dérive des continents

- Traduire le monde : la Syrie ou la République arabe syrienne?

- Traduire le monde : Le développement démocratique?

- Traduire le monde : Le monde islamique

- Traduire le monde : Le néerlandais pour tous

- Traduire le monde : Le plat pays du flamand traduit

- Traduire le monde : Le pluriel de taliban

- Traduire le monde : les adresses à l’étranger

- Traduire le monde : Les Bagdadis?

- Traduire le monde : Les États américains revisités

- Traduire le monde : Les États-Uniques

- Traduire le monde : Les fourches caudines et autres expressions historiques

- Traduire le monde : Les gentilés et toponymes composés

- Traduire le monde : Les majuscules dans les noms de pays

- Traduire le monde : Les Nations Unies

- Traduire le monde : Les noms américains : traduire ou pas?

- Traduire le monde : les noms de capitales

- Traduire le monde : les noms de guerres et de révolutions

- Traduire le monde : les noms de ministères

- Traduire le monde : Les noms d’universités

- Traduire le monde : Les parlements

- Traduire le monde : Les partis politiques et leurs membres

- Traduire le monde : Les sigles en relations internationales

- Traduire le monde : les unités monétaires

- Traduire le monde : Le Timor-Oriental et autres pays

- Traduire le monde : Le vocabulaire politique britannique

- Traduire le monde : L’île mystérieuse

- Traduire le monde : L’Iraq ou l’Irak?

- Traduire le monde : L’Utopie, ou ces pays qui n’existent pas

- Traduire le monde : Macédoine, Monténégro et République tchèque

- Traduire le monde : Malaisie ou Malaysia?

- Traduire le monde : Mers et monde

- Traduire le monde : Mumbai ou Bombay?

- Traduire le monde : Mythes et toponymes

- Traduire le monde : Places publiques et monuments étrangers

- Traduire le monde : Poutine en français et Putin en anglais. Pourquoi?

- Traduire le monde : Que faire avec les noms d’organismes étrangers?

- Traduire le monde : Scandinavie, pays nordiques ou Europe du Nord?

- Traduire le monde : Splendeurs et misères de la typographie

- Traduire le monde : Sud-Soudan ou Soudan du Sud?

- Traduire le monde : Toponymes disparus

- Traduire le monde : Traduire les noms propres?

- Traduire le monde : Turqueries

- Traduire le monde : Venise du Nord et autres surnoms

- Traduire pour l’aviation civile et militaire

- Traduire should

- Twitter fait gazouiller!

- Une femme-orchestre et un homme au foyer : l’innovation et la norme dans les expressions non sexistes

- Une sœur d’arme et un père poule : l’innovation et la norme dans les expressions non sexistes (2e partie)

- Une traductrice médicale à la finale masculine de Wimbledon ou le problème de l’hypallage

- Un hommage gaspéen ou gaspésien?

- Un hommage gaspéen ou gaspésien? …la suite

- Un interdit affecté par l’usage

- Un lexique parlementaire trilingue

- Un mot pittoresque et perfide : Challenge

- Voisinage et collisions

- Voyage singulier des Escoumins aux Saintes-Maries-de-la-Mer

- WeBiText à la rescousse

- « Webmaster »

- Whichever is the later, the earlier, the lower, etc.

- Without prejudice

Divulgation proactive

Avis important

La présente version de l'outil Chroniques de langue a été archivée et ne sera plus mise à jour jusqu'à son retrait définitif.

Veuillez consulter la version remaniée de l'outil Chroniques de langue pour obtenir notre contenu le plus à jour, et n'oubliez pas de modifier vos favoris!

La zone de recherche et les fonctionnalités

Les jeux de caractères et leurs mystères…

J’ai connu mes premiers soucis relatifs aux jeux de caractères en 1984 ou 1985, à commencer par la définition de ce qu’est un jeu de caractères, du point de vue de l’informatique en particulier.

L’anglais et le français s’écrivent avec 26 lettres et 10 chiffres et un certain nombre d’accents et de signes de ponctuation. L’informatique a d’abord utilisé des jeux de caractères limités aux lettres majuscules, aux chiffres et à certains signes de ponctuation.

Ainsi, en 1972, j’ai travaillé pour la compagnie de télécommunications CNCP et constaté que les télégrammes utilisaient un jeu de caractères qui ne comprenait ni lettres accentuées ni majuscules. Le jeu de caractères était celui des téléscripteurs, fondé sur le code Baudot1.

Un jeu de caractères est en fait une convention ou une norme reconnue par un certain nombre d’utilisateurs. Au fil des ans, des jeux de caractères plus ou moins complets ont vu le jour. L’un des plus connus fut le code ASCII, qui comportait 128 caractères2 comprenant les lettres majuscules et minuscules, mais pas les accents ni les ligatures comme le œ dans œuf.

Dans un ordinateur, un code est assigné à chaque caractère pour représenter ces valeurs abstraites de symboles.

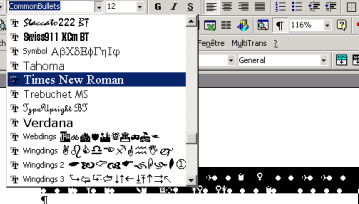

Un caractère peut être représenté de diverses façons par diverses polices de caractères et divers attributs (gras, italique, etc.) de la police. Il arrive que certaines polices ne contiennent pas tous les caractères d’un jeu donné.

Permettez-moi un raccourci peu orthodoxe pour vous dire que l’ordinateur stocke des valeurs numériques qui représentent les divers caractères qu’il manipule3.

Par exemple, en ASCII, le caractère « A » est représenté par le code 65, « B » par 66, etc.

Cependant, chaque nouvelle plate-forme (combinaison système d’exploitation et matériel) a plus ou moins connu son propre codage, généralement limité à 256 caractères4. En passant, pour un ordinateur, « A » et « a » sont des caractères différents.

Dans les années 80, j’ai utilisé le PC (IBM), l’Apple II et le Mac (Apple), l’Amiga (Amiga), le Vic 20 et le C64 (Commodore) et j’ai vu fonctionner d’autres ordinateurs moins courants. La plupart utilisaient le code ASCII et lui avaient ajouté d’autres caractères, qu’il s’agisse de lettres accentuées ou de symboles graphiques pour les dessins.

Évidemment, les codes attribués aux lettres accentuées n’étaient pas les mêmes d’un fabricant à l’autre; il n’y avait pas de norme. Par exemple, sur un PC, le code 130 donnait un caractère « é », tandis qu’il donnait un « Ç » sur un Mac.

Non seulement chaque fabricant d’ordinateurs avait sa propre extension de l’ASCII, mais il en était de même pour chaque fabricant d’imprimante. Histoire de faire travailler un peu plus les neurones des utilisateurs, les concepteurs d’imprimantes avaient même prévu des variantes qu’on obtenait en configurant de minuscules commutateurs binaires. Il fallait d’abord trouver les commutateurs généralement dissimulés sous la tête d’impression ou dans un autre endroit aussi difficile d’accès. La documentation était tout aussi géniale…

En 1987-1988, peu après mon entrée au Bureau de la traduction, j’ai vu arriver les premiers Ogivar (des micro-ordinateurs). Le pauvre technicien chargé de configurer les imprimantes, un certain Roger Racine5, m’avait demandé un coup de main.

À cette époque, un PC coûtait beaucoup moins cher qu’un Mac, mais n’offrait pas encore de majuscules accentuées d’emblée. Il fallait donc modifier la police de caractères. Un logiciel faisait le travail pour l’affichage, mais pour l’imprimante, c’est M. Racine qui a écrit le code. La rumeur veut qu’un barbu lui ait refilé un coup de main.

Nous avions donc détourné les codes assignés à des caractères graphiques ou grecs pour nos caractères accentués.

Je suis persuadé que Roger Racine a gardé un souvenir fabuleux de cette expérience. Pour dessiner un caractère, il fallait connaître le nombre de lignes de points par caractères d’une imprimante (8 à 24 selon la qualité de l’imprimante).

Pour représenter la forme d’un caractère à l’imprimante, l’ordinateur utilisait la valeur de quelques octets superposés6. Un caractère était représenté dans un octet composé de 8 bits (valeurs de 0 ou de 1) et pouvait contenir une valeur comprise entre 0 et 255.

En mode binaire, zéro s’écrit 00000000, et 255 s’écrit 11111111. Pour l’affichage, chaque 0 ou 1 représente un point (pixel) qui sera imprimé quand c’est un 1.

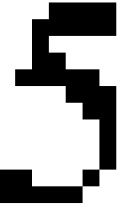

Afin de mieux visualiser la chose, voici une illustration d’un chiffre agrandi et de sa représentation à l’aide d’une douzaine d’octets. Les zéros seraient transparents à l’impression.

0 0 0 0 1 1 1 1

0 0 0 1 1 1 1 1

0 0 0 1 0 0 0 0

0 0 0 1 1 0 0 0

0 0 1 1 1 1 1 0

0 0 0 0 0 1 1 1

0 0 0 0 0 0 1 1

0 0 0 0 0 0 0 1

0 0 0 0 0 0 0 1

0 0 0 0 0 0 0 1

0 1 1 0 0 0 1 0

0 1 1 1 1 1 0 0

1 1 1 1

1 1 1 1 1

1

1 1

1 1 1 1 1

1 1 1

1 1

1

1

1

1 1 1

1 1 1 1 1

Dans le deuxième cas, j’ai remplacé les zéros par des espaces.

Pour créer une majuscule accentuée, on réduisait sa taille d’au moins deux lignes, qu’on réservait au dessin de l’accent voulu :

| Accent aigu | Accent grave | Accent circonflexe | Tréma |

|---|---|---|---|

| 00001000 00010000 | 00010000 00001000 | 00001000 00010100 | 00100100 00000000 |

Ensuite, il ne restait qu’à télécharger notre nouvelle police de caractères dans l’imprimante.

Et de nos jours?

On serait porté à croire que les problèmes de caractères accentués n’affectent que les lecteurs francophones, mais le langagier qui doit traduire un texte dont tous les caractères accentués sont déformés ou effacés est mal pris lui aussi.

Croyez-le ou non, il existe encore des parties d’Internet où les seuls caractères reconnus sont ceux de l’ASCII (128 caractères). Voyez un peu à quoi ressemblait l’appel dans un courriel que j’ai reçu d’une organisation qui traite notamment de localisation :

Dear Andr,

[…]

Imaginez un peu une demande de traduction à partir d’un courriel où tous les mots accentués sont ainsi tronqués… Le fameux « Être ou ne pas être » devient « tre ou ne pas tre », « têtu » devient « ttu », « été » devient « t », etc.

Quand ça arrive, suggérez au client de copier le tout dans un fichier Word ou WordPerfect. Contrairement au texte, les pièces jointes n’ont pas à être interprétées par les passerelles d’Internet; elles arrivent généralement saines et sauves. Par contre, une page Web ou un fichier texte pourraient subir les horreurs du 128 bits.

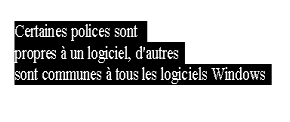

Un autre problème fréquent lié aux jeux de caractères et aux polices pourrait vous tomber dessus même si vous n’avez pas à traduire ou à lire en français : quand une personne vous envoie un texte écrit avec une police qui n’existe pas sur votre ordinateur, la substitution automatique choisit parfois une police du genre ![]() (Wingdings).

(Wingdings).

Si vous arrivez à lire le message… vous êtes un mutant.

Ça m’arrive tout le temps quand quelqu’un m’envoie un message en WordPerfect (qui n’est plus sur mon ordinateur à la maison). Je peux ouvrir le document avec Word, mais s’il a choisi une police WordPerfect plutôt qu’une police Windows (Arial, Times, etc.), ça donne à peu près ceci :

Si ça vous arrive, pas de panique. Il suffit de sélectionner le texte, puis d’appliquer une autre police de caractères.

Unicode, la solution, mais…

256 codes, pour l’anglais et le français, c’est bien. Par contre, pour les langues qui utilisent des milliers de symboles, c’est un peu limité. On a donc vu apparaître des codages sur plus d’un octet. Un codage sur deux octets (16 bits) permet plus de 60 000 codes. Certains jeux de caractères à deux octets (DBCS = double byte character set) ont été conçus pour les langues qui utilisent des milliers de symboles.

Afin de n’avoir qu’un code permettant de représenter tous les caractères de toutes les langues humaines (et même artificielles), des chercheurs ont élaboré Unicode.

Unicode simplifie la vie des programmeurs et des utilisateurs. On assiste de plus en plus à une mouvance vers Unicode, qui est la valeur par défaut pour le HTML, qui s’intègre parfaitement au XML, etc.

Cependant, la transition vers Unicode nous joue parfois de vilains tours. Il arrive que des documents comportent à la fois des caractères Unicode et des caractères Windows (dits ANSI) et parfois des caractères provenant du soi-disant ASCII étendu. Quand on a omis de préciser, dans les pages HTML, quel jeu de caractères a été utilisé, le navigateur prend la valeur par défaut (Unicode UTF-8), une des moutures de Unicode7.

Vous pouvez aussi avoir un problème avec les caractères faisant partie de polices qui ne se trouvent pas sur votre ordinateur, notamment pour le chinois ou le japonais (que vous possédez si vous pouvez lire ces langues, bien entendu).

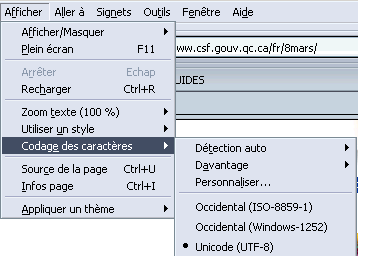

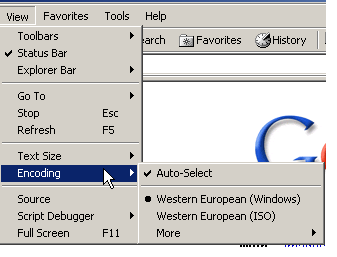

Si les caractères sont accentués, le texte devient illisible. Quand cela arrive, vous pouvez facilement corriger la situation. Il suffit d’aller au menu Affichage et de choisir un codage différent :

Les appellations varient quelque peu selon les navigateurs, comme vous pouvez le constater.

Si Unicode est sélectionné, on passera à 8859-1(ISO) ou Windows. Si l’un des deux premiers est sélectionné, on passera à Unicode et 99 % du temps, on obtiendra un affichage correct.

En passant, si la sélection (ou détection) automatique est activée, le problème est moins fréquent. Je vous suggère donc d’activer cette option si ce n’est déjà fait.

Comme je l’indiquais plus haut, il peut aussi arriver que des fichiers contiennent plus d’un jeu de caractères. L’an dernier, j’ai eu le plaisir de voir un fichier qui contenait à la fois des caractères en UTF-8 (Unicode) ET des caractères provenant de l’ASCII étendu.

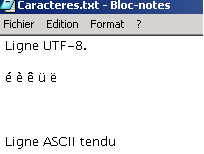

Un fichier texte enregistré en UTF-8 comporte de l’information qui précise sa nature. L’ouverture à partir du Bloc-notes donne donc une interprétation qui dissimule les caractères accentués provenant de l’ASCII étendu.

Par contre, si le même fichier est ouvert à partir de Word, ces caractères s’affichent… mais sont interprétés selon le jeu Windows (différent de l’ASCII étendu).

L’ennui, voyez-vous, c’est que dans ce fichier identifié UTF-8, un processus ou une personne avait introduit des caractères de type ASCII étendu.

Quand j’ouvrais à partir du Bloc-notes de Windows, j’obtenais quelque chose qui ressemble à ceci :

La ligne de caractères accentués sous ASCII étendu disparaît complètement…

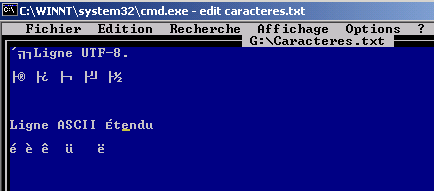

Voici ce que le même texte donne en DOS avec l’éditeur Edit.

Cette fois, c’est le UTF-8 qui en prend un coup.

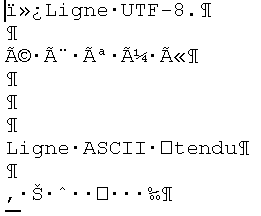

Voici ce qu’on voit à partir de Word :

J’avoue que je n’ai pas beaucoup ri quand je cherchais la solution, pourtant toute simple.

Puisque je pouvais voir en DOS les caractères de l’ASCII étendu, et que je pouvais voir les autres caractères à partir du Bloc-notes, il suffisait de quelques remplacements globaux. Non pas caractère pour caractère – ç’aurait été trop simple –, mais balise pour balise.

En DOS :

É sera remplacé par Emajaigu, é par eaigu.

È sera remplacé par Egrave, è par egrave, et ainsi de suite.

J’ai procédé de la sorte pour tous les caractères qui passent mal, essentiellement les caractères accentués, les guillemets et un ou deux autres.

Dans le Bloc-notes, j’ai fait l’opération inverse. Le tour était joué.

Honnêtement, j’espère que ça ne vous arrivera jamais. Si cela se produisait, vous vous souviendrez peut-être de cette chronique…

Je sais que ça arrivera un jour, et ce jour-là, vous saurez que je n’ai pas expliqué cette histoire juste pour le plaisir. Si ça vous arrive et que votre client est un technicien, envoyez-moi sa photo pour que je voie l’expression sur son visage quand vous arriverez avec la solution.

Notes

- 1 Les « vieux de la vieille » se souviendront qu’on parlait de bauds par seconde au lieu de bits par seconde quand on utilisait un modem. C’était donc le nombre de caractères transmis par seconde. Ensuite, on vit apparaître le kbps (kilobits par seconde).

- 2 Le code à 256 caractères n’était pas ASCII et chaque compagnie avait sa mouture.

- 3 En fait, il stocke seulement des 1 et des 0 regroupés.

- 4 Les ordinateurs manipulaient des octets (8 bits) permettant de représenter des valeurs de 0 à 255.

- 5 Aujourd’hui directeur, Gestion de la technologie au Bureau de la traduction.

- 6 Encore une fois, selon le nombre de lignes de points par caractère.

- 7 Unicode existe en plusieurs versions, mais c’est la plus courante.

© Services publics et Approvisionnement Canada, 2025

TERMIUM Plus®, la banque de données terminologiques et linguistiques du gouvernement du Canada

Outils d'aide à la rédaction – Chroniques de langue

Un produit du Bureau de la traduction